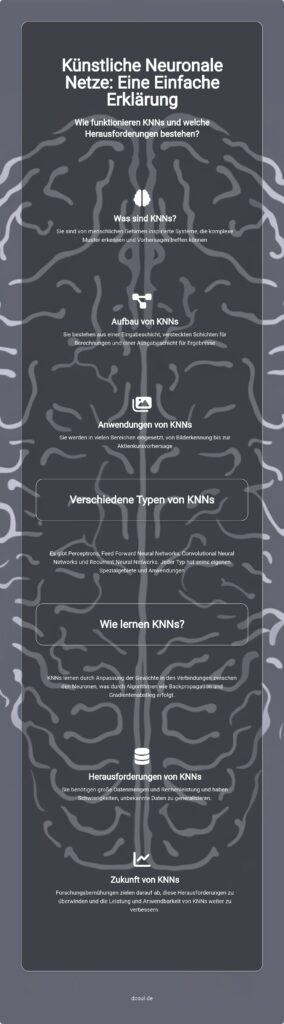

Künstliche Neuronale Netze (KNN) sind faszinierende Algorithmen, die das menschliche Gehirn nachahmen und komplexe Muster in Daten erkennen.

Sie sind in der Lage, Vorhersagen zu treffen und uns in den unterschiedlichsten Bereichen zu unterstützen.

In diesem Artikel erkläre ich, was neuronale Netze einfach erklärt, wirklich bedeutet und wie sie funktionieren.

Wir werden die Struktur von KNNs, ihre Anwendungsbereiche und die verschiedenen Arten von KNNs kennenlernen.

Zudem werfen wir einen Blick auf die Herausforderungen und Grenzen dieser Technologie.

Begleiten Sie mich auf dieser spannenden Reise in die Welt der Künstlichen Neuronalen Netze.

Was sind Künstliche Neuronale Netze (KNN)?

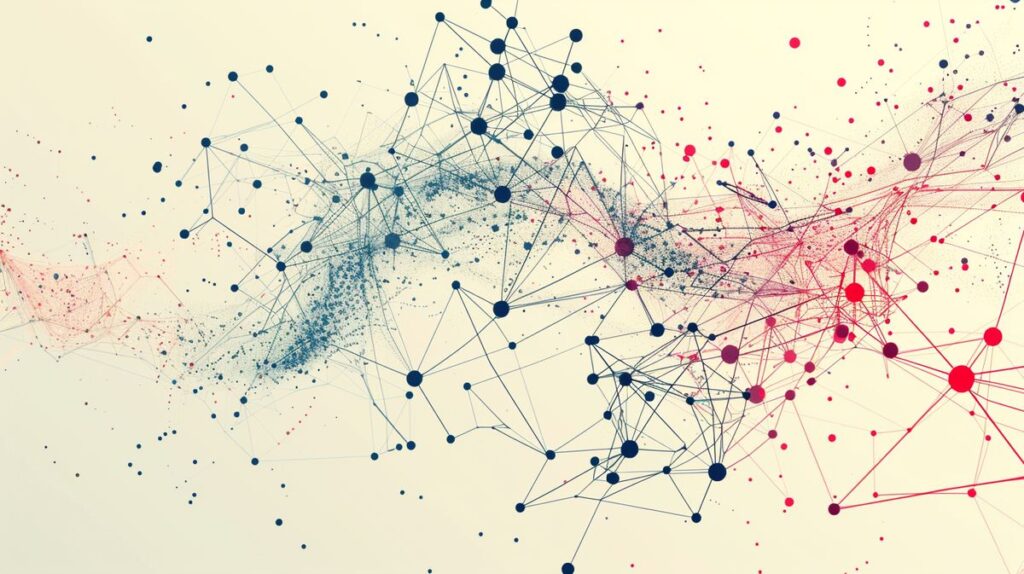

Künstliche Neuronale Netze (KNN) sind Algorithmen, die nach dem Vorbild des menschlichen Gehirns entwickelt wurden. Sie sind ein zentraler Bestandteil der künstlichen Intelligenz und ermöglichen es Maschinen, zu lernen und komplexe Muster in Daten zu erkennen. Die Hauptfunktion von KNNs besteht darin, aus vorhandenen Daten Vorhersagen zu treffen und Entscheidungen zu treffen. Damit sind sie ein Schlüsselwerkzeug, um neuronale Netze einfach zu erklären.

Die Struktur von Künstlichen Neuronalen Netzen

Ein KNN besteht aus mehreren Schichten, die jeweils aus einer Vielzahl von Knoten oder Neuronen bestehen. Die grundlegende Struktur von KNNs umfasst eine Eingabeschicht, eine oder mehrere verborgene Schichten und eine Ausgabeschicht.

Eingabeschicht, verborgene Schichten und Ausgabeschicht

Die Eingabeschicht nimmt die Daten auf, die das Netzwerk verarbeiten soll. Die verborgenen Schichten verarbeiten diese Daten und führen komplexe Berechnungen durch. Die Ausgabeschicht liefert schließlich das Ergebnis des Netzwerks. Jede Schicht hat eine spezifische Funktion und trägt dazu bei, die Leistungsfähigkeit des KNN zu erhöhen.

Knoten und Neuronen in KNNs

Die Knoten oder Neuronen in einem KNN sind die grundlegenden Verarbeitungseinheiten. Jedes Neuron nimmt Eingaben von anderen Neuronen entgegen, verarbeitet diese und gibt das Ergebnis an nachfolgende Neuronen weiter. Die Art und Weise, wie diese Neuronen miteinander verbunden sind und interagieren, bestimmt die Fähigkeit des Netzwerks, Muster zu erkennen und Vorhersagen zu treffen.

Gewichtete Verbindungen zwischen Neuronen

Die Verbindungen zwischen den Neuronen in einem KNN sind gewichtet. Diese Gewichte bestimmen, wie stark die Ausgabe eines Neurons die Eingabe eines anderen Neurons beeinflusst. Die Gewichte werden im Laufe des Lernprozesses angepasst, um die Leistung des Netzwerks zu verbessern.

Sie sind ein entscheidender Faktor für die Informationsübertragung in KNNs und tragen wesentlich dazu bei, neuronale Netze einfach zu erklären.

Anwendungsbereiche von Künstlichen Neuronalen Netzen

Künstliche Neuronale Netze (KNNs) sind unglaublich vielseitig und finden in vielen Bereichen Anwendung. Von der Bilderkennung über die Sprachverarbeitung bis hin zur Vorhersage von Aktienkursen – KNNs sind überall. Lass uns gemeinsam diese spannenden Anwendungsbereiche von KNNs erkunden und die Welt der neuronalen Netze einfach erklärt entdecken.

Bilderkennung und KNNs

Die Bilderkennung ist ein klassisches Anwendungsgebiet von KNNs. Sie spielen eine entscheidende Rolle bei der Identifizierung und Klassifizierung von Bildern. Beispielsweise können sie dazu verwendet werden, Gesichter auf Fotos zu erkennen oder Objekte in Bildern zu identifizieren. Dies ist besonders nützlich in Bereichen wie der Überwachungstechnik, der medizinischen Bildanalyse und der Fotografie.

Sprachverarbeitung durch KNNs

Auch in der Sprachverarbeitung sind KNNs unverzichtbar. Sie helfen dabei, gesprochene oder geschriebene Sprache zu verstehen, zu übersetzen und sogar zu generieren. Denk nur an die Sprachassistenten auf deinem Smartphone oder die automatischen Übersetzungen in deinem E-Mail-Programm. All das wäre ohne die Fähigkeiten von KNNs in der Sprachverarbeitung nicht möglich.

Autonomes Fahren und die Rolle von KNNs

Das autonome Fahren ist ein weiterer spannender Anwendungsbereich von KNNs. Sie helfen dabei, die Umgebung des Fahrzeugs zu erkennen und zu interpretieren, und treffen Entscheidungen auf Basis dieser Informationen. Ob es darum geht, Fußgänger auf der Straße zu erkennen oder den optimalen Fahrweg zu berechnen – KNNs sind ein unverzichtbarer Bestandteil der Technologie hinter dem autonomen Fahren.

Medizinische Diagnosen und Vorhersagen von Aktienkursen mit KNNs

Aber KNNs sind nicht nur in der Technologiebranche im Einsatz. Sie spielen auch eine wichtige Rolle in der Medizin und der Finanzwelt. In der Medizin können sie beispielsweise dabei helfen, Krankheiten zu diagnostizieren oder die Wirksamkeit von Behandlungen vorherzusagen. In der Finanzwelt werden sie verwendet, um Aktienkurse zu prognostizieren und Handelsentscheidungen zu treffen. Es ist faszinierend, wie vielseitig KNNs sind und wie sie uns in so vielen verschiedenen Bereichen unterstützen können.

Zusammenfassend lässt sich sagen, dass KNNs eine Schlüsseltechnologie sind, die in vielen verschiedenen Bereichen Anwendung findet. Sie helfen uns dabei, komplexe Muster in Daten zu erkennen und Vorhersagen zu treffen, und sie machen unser Leben auf vielfältige Weise einfacher und effizienter. In diesem Sinne hoffe ich, dass du nun ein besseres Verständnis davon hast, was KNNs sind und wie sie funktionieren. Denn das ist es, was ich mit „neuronale Netze einfach erklärt“ meine.

Verschiedene Arten von Künstlichen Neuronalen Netzen

Um neuronale Netze einfach erklärt zu bekommen, ist es wichtig, die verschiedenen Typen von Künstlichen Neuronalen Netzen (KNNs) zu verstehen. Es gibt mehrere Arten von KNNs, die sich in ihrer Struktur und Funktionsweise unterscheiden. Dazu gehören Perceptrons, Feed Forward Neural Networks, Convolutional Neural Networks und Recurrent Neural Networks.

Perceptrons: Die einfachste Form von KNNs

Beginnen wir mit den Perceptrons, der einfachsten Form von KNNs. Ein Perceptron ist ein KNN, das aus nur einem einzigen Neuron besteht. Es erhält mehrere Eingaben, verarbeitet diese und gibt ein Ergebnis aus. Perceptrons sind die Grundbausteine für komplexere KNNs und werden oft in einfacheren KNN-Anwendungen eingesetzt.

Feed Forward Neural Networks: Verarbeitung von Informationen in einer Richtung

Feed Forward Neural Networks sind eine weitere Art von KNNs. Sie sind so benannt, weil sie Informationen in einer Richtung verarbeiten, von der Eingabeschicht über die verborgenen Schichten zur Ausgabeschicht. Dieser lineare Informationsfluss ermöglicht es ihnen, komplexe Muster in Daten zu erkennen und Vorhersagen zu treffen.

Convolutional Neural Networks: Spezialisiert auf Bildverarbeitung

Convolutional Neural Networks (CNNs) sind eine spezielle Art von KNNs, die auf die Verarbeitung von Bildern spezialisiert sind. CNNs sind in der Lage, Muster in Bildern zu erkennen, indem sie kleine, überlappende Teile des Bildes analysieren. Sie sind besonders nützlich in Bereichen wie der Bilderkennung und der Bildklassifizierung.

Recurrent Neural Networks: KNNs mit „Gedächtnis“

Zuletzt gibt es noch die Recurrent Neural Networks (RNNs). Im Gegensatz zu den anderen KNNs haben RNNs die Fähigkeit, Informationen über mehrere Durchläufe hinweg zu speichern. Diese „Gedächtnis“-Funktion macht sie besonders nützlich für Aufgaben, die eine Analyse von Sequenzen erfordern, wie zum Beispiel die Spracherkennung oder die Vorhersage von Zeitreihen.

Jeder dieser KNN-Typen hat seine speziellen Anwendungsbereiche und bringt seine eigenen Vorteile und Herausforderungen mit sich. In den folgenden Abschnitten werden wir tiefer in die Funktionsweise dieser verschiedenen Arten von KNNs eintauchen.

Wie lernen Künstliche Neuronale Netze?

Künstliche Neuronale Netze (KNNs) sind in der Lage, aus Erfahrung zu lernen. Aber wie genau funktioniert das? Um neuronale Netze einfach erklärt zu bekommen, müssen wir uns ansehen, wie sie sich anpassen und verbessern, um bessere Vorhersagen zu treffen.

Anpassung der Gewichte und Backpropagation

In KNNs spielen Gewichte eine entscheidende Rolle. Sie beeinflussen, wie stark die Eingaben eines Neurons die Aktivierung des Neurons und damit die Ausgabe des Netzes beeinflussen. Das Anpassen dieser Gewichte ist ein zentraler Bestandteil des Lernprozesses. Ein häufig verwendeter Algorithmus für diese Anpassung ist die sogenannte Backpropagation. Dabei wird der Fehler, den das Netz bei einer Vorhersage gemacht hat, von der Ausgabeschicht zurück durch das Netz bis zur Eingabeschicht „propagiert“. Auf dieser Basis werden dann die Gewichte angepasst.

Bedeutung der Lernrate (η) im Trainingsprozess

Ein weiterer wichtiger Faktor im Lernprozess von KNNs ist die Lernrate (η). Sie bestimmt, wie stark die Gewichte bei jedem Lernschritt angepasst werden. Ist die Lernrate zu hoch, kann das Netz über das optimale Gewicht „hinausschießen“ und instabil werden. Ist sie hingegen zu niedrig, lernt das Netz sehr langsam oder bleibt in suboptimalen Zuständen stecken. Die Wahl der richtigen Lernrate ist daher entscheidend für den Erfolg des Trainings.

Der Gradientenabstieg: Systematische Anpassung der Gewichte

Der Gradientenabstieg ist eine Methode, um die Gewichte in KNNs systematisch anzupassen. Dabei wird in jedem Schritt in die Richtung des steilsten Abstiegs im Fehlergradienten gegangen, um den Gesamtfehler des Netzes zu minimieren. Dieser Prozess wird solange wiederholt, bis ein Minimum erreicht ist, also die Gewichte gefunden sind, die den kleinstmöglichen Fehler erzeugen.

Transfer Learning: Anpassung von Modellen für verwandte Aufgaben

Ein weiterer spannender Aspekt beim Lernen von KNNs ist das sogenannte Transfer Learning. Hierbei wird ein bereits trainiertes Modell auf eine neue, aber verwandte Aufgabe angewendet. Das Modell „transferiert“ also sein gelerntes Wissen auf die neue Aufgabe und muss nur noch feinjustiert werden. Dies kann enorm viel Zeit und Rechenleistung sparen, insbesondere wenn große Datenmengen für das Training benötigt werden.

Mit diesen Informationen sollte das Thema neuronale Netze einfach erklärt sein. Wie du siehst, ist das Lernen von KNNs ein faszinierender Prozess, der viele Aspekte umfasst und ständig weiterentwickelt wird.

Herausforderungen und Grenzen von Künstlichen Neuronalen Netzen

Künstliche Neuronale Netze (KNNs) sind ein mächtiges Werkzeug in der Welt der Künstlichen Intelligenz. Sie ermöglichen es uns, komplexe Muster in Daten zu erkennen und Vorhersagen zu treffen. Aber wie bei jeder Technologie gibt es auch bei KNNs Herausforderungen und Grenzen. In diesem Abschnitt möchte ich, Elena, diese Herausforderungen genauer erklären, um das Thema neuronale netze einfach erklärt weiter zu vertiefen.

Der Bedarf an großen Datenmengen und Rechenleistung

Eine der größten Herausforderungen bei der Arbeit mit KNNs ist der Bedarf an großen Datenmengen und Rechenleistung. KNNs lernen durch Erfahrung, was bedeutet, dass sie eine große Menge an Daten benötigen, um Muster zu erkennen und genaue Vorhersagen zu treffen. Darüber hinaus erfordert die Verarbeitung dieser Daten eine erhebliche Rechenleistung. Dies kann insbesondere für kleinere Unternehmen oder Forschungseinrichtungen ein Hindernis darstellen, da die Kosten für die notwendige Hardware und die Speicherung der Daten hoch sein können.

Fehleranfälligkeit bei unbekannten Daten

Eine weitere Herausforderung bei der Arbeit mit KNNs ist ihre Fehleranfälligkeit bei unbekannten Daten. Während KNNs sehr gut darin sind, Muster in den Daten zu erkennen, mit denen sie trainiert wurden, können sie bei neuen, unbekannten Daten, die von diesen Mustern abweichen, Fehler machen. Dies kann dazu führen, dass die KNNs ungenaue oder sogar falsche Vorhersagen treffen.

Aktuelle Forschung und Verbesserung von KNNs

Trotz dieser Herausforderungen gibt es viele spannende Entwicklungen in der Forschung zu KNNs. Forscher arbeiten ständig an neuen Algorithmen und Techniken, um die Genauigkeit von KNNs zu verbessern, ihren Bedarf an Daten und Rechenleistung zu reduzieren und ihre Fähigkeit, mit unbekannten Daten umzugehen, zu verbessern. Einige dieser Forschungsansätze konzentrieren sich auf die Entwicklung von KNNs, die in der Lage sind, aus kleineren Datenmengen zu lernen, oder auf die Verbesserung der Effizienz von KNNs durch die Verwendung von spezialisierter Hardware oder optimierten Algorithmen.

Zusammenfassend lässt sich sagen, dass KNNs trotz ihrer Herausforderungen und Grenzen ein mächtiges Werkzeug in der Künstlichen Intelligenz sind. Mit fortlaufender Forschung und Entwicklung werden wir wahrscheinlich sehen, wie diese Herausforderungen überwunden werden und KNNs noch effektiver und zugänglicher werden.

Fazit: Neuronale Netze einfach erklärt

Nachdem wir uns intensiv mit dem Thema „Neuronale Netze einfach erklärt“ auseinandergesetzt haben, wollen wir nun die wichtigsten Punkte zusammenfassen. Künstliche Neuronale Netze (KNNs) sind Algorithmen, die nach dem Vorbild des menschlichen Gehirns entwickelt wurden. Ihre Hauptfunktion ist die Erkennung komplexer Muster in Daten und das Treffen von Vorhersagen.

Die grundlegende Struktur von KNNs besteht aus einer Eingabeschicht, verborgenen Schichten und einer Ausgabeschicht. Jede Schicht hat spezifische Funktionen und besteht aus Knoten bzw. Neuronen, die durch gewichtete Verbindungen miteinander verbunden sind. Diese Verbindungen spielen eine entscheidende Rolle bei der Informationsübertragung in KNNs.

KNNs finden Anwendung in einer Vielzahl von Bereichen, darunter Bilderkennung, Sprachverarbeitung, autonomes Fahren und medizinische Diagnosen. Es gibt verschiedene Arten von KNNs, darunter Perceptrons, Feed Forward Neural Networks, Convolutional Neural Networks und Recurrent Neural Networks, die jeweils ihre spezifischen Eigenschaften und Anwendungsbereiche haben.

Das Lernen und Anpassen von KNNs erfolgt durch Anpassung der Gewichte und Backpropagation, wobei die Lernrate (η) und der Gradientenabstieg eine wichtige Rolle spielen. Transfer Learning ermöglicht die Anpassung von Modellen für verwandte Aufgaben.

Trotz ihrer beeindruckenden Fähigkeiten haben KNNs auch ihre Herausforderungen und Grenzen. Dazu gehören der Bedarf an großen Datenmengen und Rechenleistung sowie ihre Fehleranfälligkeit bei unbekannten Daten. Aktuelle Forschungsbemühungen konzentrieren sich auf die Verbesserung dieser Aspekte.

Ich hoffe, dass dir dieser Artikel einen guten Überblick über das Thema „Neuronale Netze einfach erklärt“ gegeben hat. Falls du noch Fragen hast, zögere nicht, sie in den Kommentaren zu stellen.

FAQ: Neuronale Netze einfach erklärt

In diesem Abschnitt beantworte ich einige häufig gestellte Fragen, die dabei helfen, das Konzept der neuronalen Netze einfach zu erklären.

Was sind die Hauptanwendungsbereiche von Künstlichen Neuronalen Netzen?

Künstliche Neuronale Netze (KNNs) finden in vielen Bereichen Anwendung. Dazu gehören Bild- und Spracherkennung, autonomes Fahren, medizinische Diagnosen und die Vorhersage von Aktienkursen.

Was sind die Unterschiede zwischen den verschiedenen Arten von KNNs?

Es gibt verschiedene Arten von KNNs, darunter Perceptrons, Feed Forward Neural Networks, Convolutional Neural Networks und Recurrent Neural Networks. Sie unterscheiden sich in ihrer Struktur, ihrer Informationsverarbeitung und ihren spezifischen Anwendungsbereichen.

Wie lernen Künstliche Neuronale Netze?

KNNs lernen durch einen Prozess namens Backpropagation. Dabei werden die Gewichte der Verbindungen zwischen den Neuronen systematisch angepasst, um die Genauigkeit der Vorhersagen zu verbessern.

Was sind die Herausforderungen und Grenzen von KNNs?

Zu den Herausforderungen von KNNs gehören der Bedarf an großen Datenmengen und Rechenleistung sowie ihre Fehleranfälligkeit bei unbekannten Daten. Aktuelle Forschungen versuchen, diese Herausforderungen zu überwinden.

Ich bin Elena, eine 32-jährige Softwareentwicklerin und Data Scientistin mit einer tiefen Leidenschaft für Open-Source-Technologien und Künstliche Intelligenz. Mit einem Masterabschluss in Informatik und umfassender Berufserfahrung im Technologiebereich bringe ich ein breites Wissen und vielfältige Erfahrungen in meinen Blog ein.

Mein besonderes Interesse gilt den Potenzialen und Herausforderungen von KI und Linux in der modernen Welt. Mit meiner Expertise und meinem Engagement fördere ich eine Community von Lesern, die bereit sind, Technologie verantwortungsbewusst und innovativ zu nutzen. Ich freue mich, mein Wissen und meine Begeisterung für diese Themen zu teilen und dazu beizutragen, das Verständnis und die Anwendung von Technologie in unserer Gesellschaft zu verbessern.